언어 전공자의 NLP 로그

Language models can explain neurons in language models 본문

글 출처 : https://openai.com/research/language-models-can-explain-neurons-in-language-models

Language models can explain neurons in language models

We use GPT-4 to automatically write explanations for the behavior of neurons in large language models and to score those explanations. We release a dataset of these (imperfect) explanations and scores for every neuron in GPT-2.

openai.com

0. 서론

- LLM의 능력이나 사용처는 확장된 데 반해 그 내부 기제를 알 수 있는 방법은 제한적이다. 예컨대 LLM이 결과를 내놓을 때 그것이 편향치를 이용한 휴리스틱의 결과물인지, 아니면 기만인지 분간해내기는 어렵다. 해석적 연구에서는 모델의 내부를 들여보며 추가적인 정보를 밝혀내고자 한다.

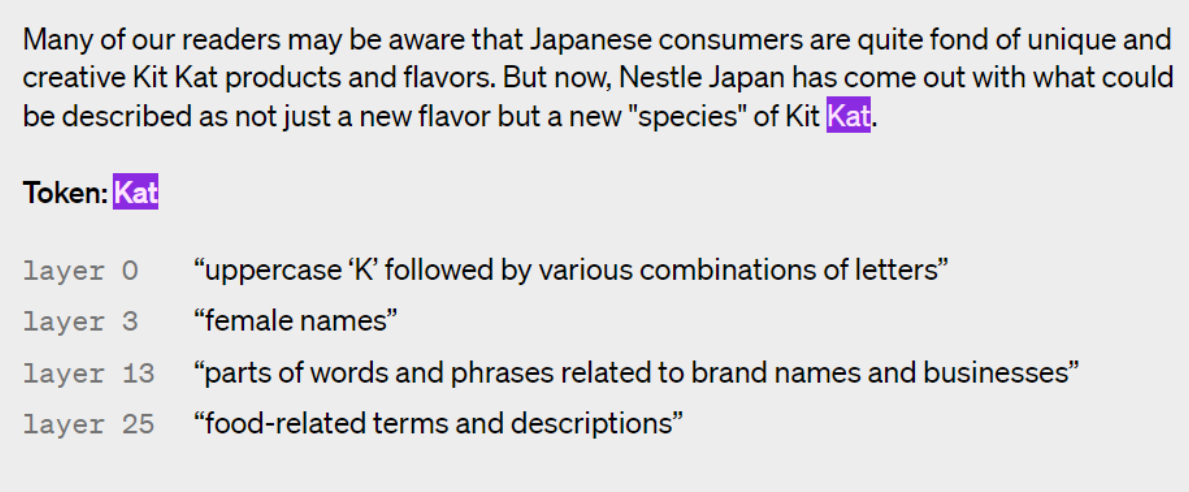

- 간단한 접근법 중 하나는 먼저 각 개별적 구성 단위 (뉴론이나 어텐션 헤드)가 무엇을 하는지 이해하는 것이다. 이전까지는 사람이 직접 뉴론을 점검하며 데이터의 어떤 특성을 반영하고 있는지 알아냈다. 이 방법은 수백억, 수천억 개의 뉴론을 가진 신경망에 적용하기 어렵다. 본문에서는 GPT-4를 활용해 뉴론 행동의 자연어적 설명을 생성하고 점수를 매겨 또다른 언어 모델의 뉴론에 적용하는 자동화 절차를 제안한다.

- 본 연구는 Our approach to alignment research의 세 번째 안건의 일부로, 정렬 연구를 자동화하려는 노력의 일환이다. 이는 AI의 발전 속도에 맞춰나갈 수 있다는 점에서 전망이 밝다. 추후 모델이 인간의 조수로서 더욱 똑똑하고 유용해지면 더 나은 설명 방식을 찾아낼 수도 있을 것이다.

1. 작동 방식

- 본 방법론은 모든 뉴론에 대하여 다음 3단계를 수행한다.

Step 1 : GPT-4를 사용해 설명 생성하기

Step 2 : GPT-4로 시뮬레이션하기

Step 3 : 비교하기

2. 발견한 것

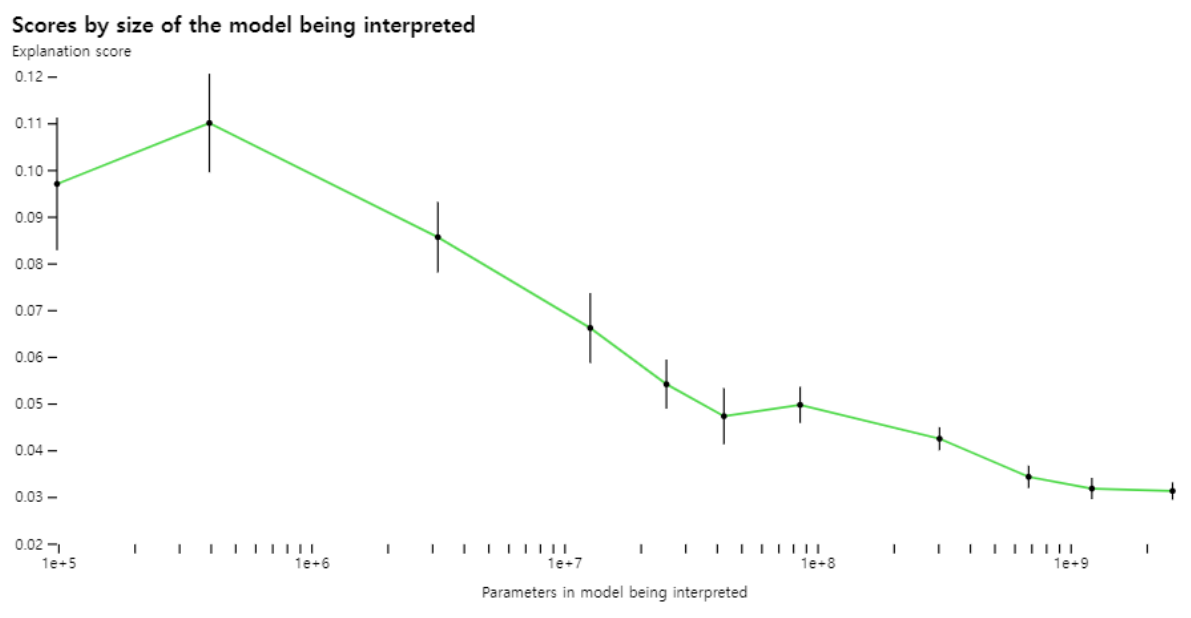

- 점수를 측정하는 방법론을 사용해 우리의 기술이 신경망의 여러 부분에서 얼마나 잘 역할을 수행하고 있는지 측정하고, 설명이 덜 된 부분에 대해서 개선을 시도할 수 있다. 예컨대 큰 모델에서는 이 기술의 성능이 떨어지는데, 이는 아마도 깊은 레이어일수록 설명하기가 어렵기 때문인 것으로 보인다.

- 대부분의 점수가 형편없긴 하지만 이제 머신러닝을 이용해 설명을 생성하는 기능을 더욱 향상시킬 수 있다. 예를 들어 다음 방식으로 점수를 개선할 수 있음을 발견했다.

*설명 반복하기* : GPT-4에게 반례를 생각해보게끔하고, 이를 반영해 다시 생성하라고 지시했을 때 스코어가 상승했다.

*더 큰 모델로 설명 생성하기* : 설명하는 모델의 성능이 좋을수록 평균 스코어는 올랐다. 그러나 GPT-4조차도 사람에 비하면 훨씬 저조한 설명 능력을 보였다.

*설명하려는 모델의 구조 바꾸기* : 다른 활성화 함수로 모델을 학습시켰을 때 스코어가 향상되었다.

- GPT-4로 GPT-2의 307,200개 뉴론을 설명한 데이터셋과 시각화 툴을 공개했다. (https://github.com/openai/automated-interpretability)

- 설명 점수가 최소 0.8의 점수를 기록한 뉴론을 1000개 이상 발견했다. 이는 GPT-4가 보기에, 그러한 설명이 뉴론의 가장 연관성 높은 행동에 해당함을 의미한다. 그닥 흥미롭지 않은 설명이 대부분이었지만, GPT-4가 이해하지 못하는 흥미로운 뉴론도 많았다. 이러한 설명을 통해 모델 연산의 양적 이해가 늘어나길 기대한다

3. 전망

- 본 연구자들은 짧은 자연어적 설명에 집중했지만, 뉴론의 작동 방식이 단순하게 설명하기 불가능할 정도로 복잡할 수도 있다. 예컨대 뉴론이 다양한 영역의 개념을 한번에 다루는 다의어적 구조일 수도 있고, 인간이 이해하지 못하거나 맞아떨어지는 단어가 없는 단일 개념을 표상하고 있을 수 있다.

- 종국에는 뉴론과 어텐션 헤드가 함께 협업하며 복잡한 행동을 보이는 전체 신경망 회로를 자동으로 찾아내고 설명하는 방식을 개발하고자 한다. 현재 방법으로는 다운스트림에 주는 영향과는 관계 없이, 입력된 텍스트 인풋에 대한 함수로만 뉴론의 행동을 설명할 수 있다. 예컨대 마침표에 활성화되는 뉴론은 다음 문자가 대문자임을 지시하거나, 문장의 카운트 수를 증가시키는 함수로 작동할 수 있다.

- 본 연구자들은 뉴론의 행동을 유발하는 메커니즘에 대해 설명하려는 시도 없이 뉴론의 행동을 설명했다. 이는 높은 점수를 낸 설명일지라도 그러한 기술 방식이 연관성 (correlation)에 기반하기 때문에 다른 분포를 보이는 텍스트에 대해서는 성능이 떨어질 수도 있다.

'논문 읽기' 카테고리의 다른 글

| BARTScore: Evaluating Generated Text as Text Generation (2) | 2024.02.29 |

|---|---|

| Multiloop Incremental Bootstrapping for Low-Resource Machine Translation (2) | 2024.02.29 |

| Aligning language models to follow instructions (0) | 2024.02.23 |

| Eight Things to Know about Language Models (0) | 2024.02.23 |

| Subword Regularization: Improving Neural Network Translation Models with Multiple Subword Candidates (0) | 2024.02.23 |